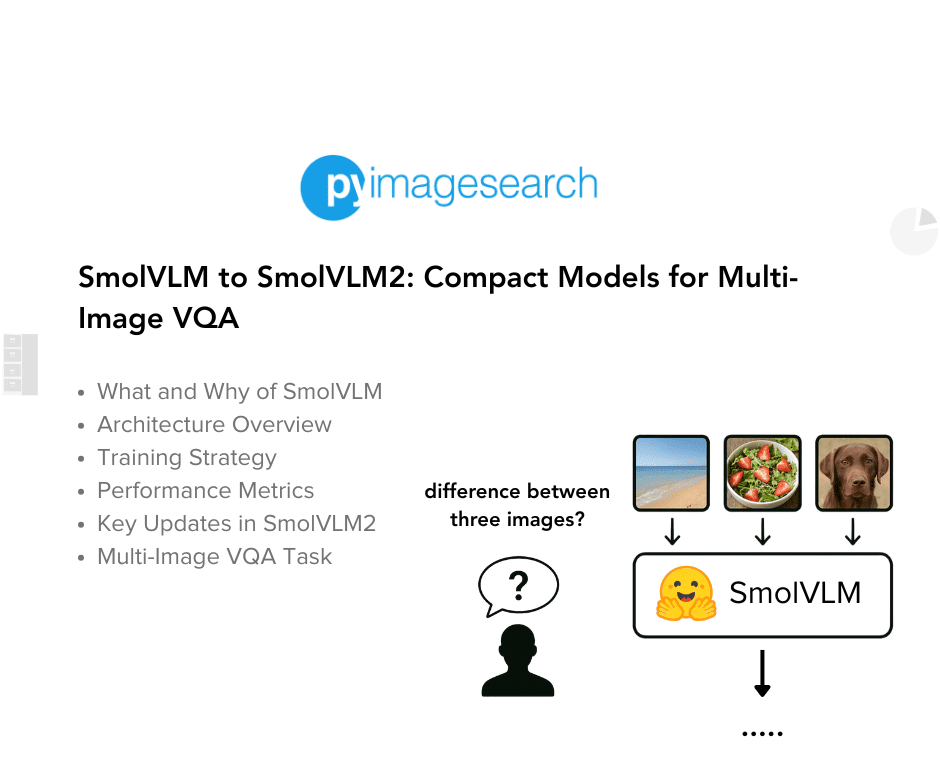

SmolVLM e SmolVLM2: IA compacta que entende imagem e vídeo (e cabe no bolso!)

Fala meu povo! Estava navegando pelos feeds de notícias de IA e esbarrei num artigo bem interessante lá no PyImageSearch falando sobre uns modelos chamados SmolVLM e SmolVLM2. Sabe, a gente vê tanto hype sobre modelos gigantescos, que ocupam data centers inteiros e precisam de placas de vídeo que custam o preço de um carro. Mas a real é que a magia da IA, muitas vezes, tá em fazer coisa grande com pouca infraestrutura. E é aí que esses 'pequenos' entram na jogada.

Por que IA Compacta Importa? (E a Saga do SmolVLM Original)

A tendência inicial em modelos de Visão-Linguagem (VLMs) foi crescer, crescer e crescer. Mas a verdade, como eu sempre digo, é que no mundo real, eficiência e custo mandam no jogo. Ter um modelo que faz o trabalho sem precisar de um supercomputador é ouro.

O SmolVLM surgiu dessa necessidade. É um VLM com "apenas" 2 bilhões de parâmetros (o que, no universo dos modelos de hoje, é considerado compacto) que foca em eficiência. Vi no artigo que ele promete ser pequeno, rápido, consumir pouca memória de GPU (coisa de 5GB para o modelo maior) e, o mais importante, é open source.

Isso abre um leque enorme de possibilidades para quem quer rodar IA direto em dispositivos, no navegador, ou até mesmo treinar modelos customizados sem falir a empresa ou precisar de um setup de R$ 50k.

Os Truques Por Trás da Magia (Arquitetura Simplificada)

Tá, mas como eles fazem um modelo pequeno entender imagem e texto de forma decente? O artigo detalha a arquitetura, e eu vou simplificar pra vocês:

Encoders e Tokens Visuais

Primeiro, eles usam uns encoders de imagem (variantes do SigLIP) pra "ler" a imagem. A sacada é que, em vez de usar um encoder gigante, eles usam um menorzinho que conversa bem com o modelo de linguagem pequeno.

O Tal do Pixel Shuffle (Sacada Mestra!)

Aqui vem a parte legal e que me chamou atenção: pra encaixar as informações da imagem no modelo de linguagem, eles usam uma técnica chamada "pixel shuffle" (ou space-to-depth). Imagina que você tem um monte de bloquinhos de informação visual espalhados numa área. Em vez de manter eles "esticados", você pega um punhado desses bloquinhos de uma pequena área e "empilha" a informação deles, criando um bloquinho mais "denso" em profundidade. Você perde um pouco da organização espacial original (o "espaço"), mas mantém a informação concentrada em mais "canais" (a "profundidade"). Vi no artigo que isso reduz drasticamente o número de tokens visuais que o modelo de linguagem precisa processar (de milhares para centenas!), o que economiza um monte de processamento e memória.

Eles ainda usam uma técnica de dividir a imagem grande em pedaços menores antes de fazer o pixel shuffle, e também incluem uma versão diminuída da imagem inteira. Isso ajuda a manter o detalhe sem explodir o tamanho da entrada para o modelo.

O Modelo de Linguagem (SmolLM2)

A espinha dorsal de texto é uma família de modelos chamada SmolLM2 (135M, 360M, 1.7B parâmetros). O ponto chave é que eles estenderam a janela de contexto desses modelos (que era pequena, tipo 2k tokens) para até 16k tokens. Isso é crucial pra conseguir processar os tokens visuais comprimidos + o texto da pergunta.

Juntando Tudo: Texto, Imagem, Posição

A forma como a informação chega no modelo é importante. Eles misturam os tokens de texto com os tokens visuais gerados pelo encoder e pixel shuffle. E aqui vem outra sacada: em vez de tentar usar texto tipo "imagem da linha 1, coluna 2" pra dizer a posição de cada pedaço da imagem, eles usam tokens especiais que o modelo aprende a associar com posições. Vi nos testes do artigo que isso fez uma diferença brutal, especialmente pra tarefas tipo ler texto na imagem (OCR).

E Vídeo?

O SmolVLM (e especialmente o SmolVLM2) também lida com vídeo. Como? Tratando cada frame importante do vídeo como uma imagem e passando pela mesma pipeline. Sem mágica de juntar frames, porque descobriram que isso piorava a performance.

Esse tipo de otimização e a possibilidade de rodar em hardware menor é exatamente o tipo de coisa que a gente discute na comunidade IA Overflow. Se você tá buscando soluções práticas e eficientes pra aplicar IA no seu negócio ou projeto, clica no link pra entrar em contato e participar da comunidade IA Overflow. É lá que a gente troca ideia de verdade sobre como botar essas coisas pra rodar no mundo real.

SmolVLM2: O Próximo Nível (Com Vídeo Mesmo!)

O SmolVLM2 chega pra turbinar a capacidade, principalmente em vídeo. Vi no artigo que ele melhora bastante em benchmarks de vídeo (Video-MME) e mantém a eficiência. São três tamanhos agora (2.2B, 500M, 256M), e mencionaram que eles são MLX Ready (pra quem mexe com Apple Silicon, isso é legal!).

Ele também deu um gás em outras áreas como matemática com imagens (MathVista), leitura de texto em imagens (OCRBench) e entendimento de diagramas. Ou seja, melhorias reais em capacidades importantes.

A Prática (Sem Código Aqui, Mas Com Onde Achar)

O artigo original lá no PyImageSearch mostra um exemplo prático de como usar o SmolVLM2-2.2B-Instruct para entender diferenças entre duas imagens. Basicamente, você carrega o modelo e o processador (usando a biblioteca transformers da Hugging Face), alimenta com as imagens e a pergunta (num formato de chat) e o modelo gera a resposta. Eles mencionaram o uso de num2words (pra converter números em texto, algo útil pra VQA) e flash-attn (pra acelerar em GPU, que é fundamental pra performance).

É o tipo de coisa que demonstra a capacidade de multi-imagem VQA de forma clara e concisa. Vale a pena ver o código no artigo original se você quiser testar!

Meu Ponto de Vista

O que eu tiro disso tudo? Que a briga não é só por quem tem o modelo maior ou mais caro. A verdadeira inovação pra mim, com a minha experiência de engenheiro e empreendedor, tá em tornar a IA acessível e útil no dia a dia e nas empresas. Modelos como SmolVLM2, que conseguem rodar em hardware modesto e entregar capacidades avançadas (visão, vídeo, texto), são cruciais para o futuro da IA aplicada.

Isso vai totalmente de encontro ao que eu penso sobre Vertical AI: pegar a tecnologia e moldar ela pra resolver um problema específico, de forma eficiente e custo-benefício. Em Deus nós confiamos, o resto me tragam dados... e modelos que rodam na prática!

Conclusão

SmolVLM e SmolVLM2 são exemplos claros de como a gente pode ter modelos de IA poderosos sem precisar de uma super infraestrutura. A inteligência tá na arquitetura inteligente (pixel shuffle, positional tokens, etc.) e no foco na eficiência. Eles trouxeram capacidades de VLM e, agora, de vídeo, para um formato que é realmente deployável em uma gama muito maior de situações.

É um movimento que vale a pena seguir de perto, porque a IA que realmente muda o jogo nem sempre é a que faz mais barulho, mas sim a que chega nas mãos de mais gente e resolve problemas reais.

Fiquem ligados para mais novidades e insights sobre IA aplicada! E se tiverem dúvidas ou quiserem trocar uma ideia, sabem onde me encontrar!

Um abraço!