Modelos de Raciocínio: A 'Ilusão' da Apple sob Novo Estudo

Fala meu povo! Lembram daquele burburinho que rolou quando a Apple publicou um artigo chamado "The Illusion of Thinking" (A Ilusão de Pensamento)? Pois é, o título já dizia tudo: a ideia era mostrar que, apesar do hype, até os modelos de raciocínio mais avançados (LRMs) tropeçam feio em tarefas que exigem um planejamento simbólico básico.

A Apple batia na tecla que a performance desses modelos caía drasticamente conforme a tarefa ficava um pouco mais complexa. Isso gerou um debate danado na comunidade de IA. Mas, como tudo em pesquisa, a história não termina aí.

Estava lendo lá no site The Decoder sobre um novo estudo feito por pesquisadores na Espanha que decidiu pegar esse artigo da Apple e refazer alguns experimentos. E olha só, eles confirmaram algumas observações da Apple, mas a interpretação e a conclusão final... ah, essas foram bem diferentes.

O que a Apple Dizia e o Que o Novo Estudo Replicou (e Contestou)

A Apple argumentou que a dificuldade está na "capacidade de pensar" dos modelos. O estudo espanhol concordou que sim, a performance cai com a complexidade. Isso foi reproduzido usando o clássico puzzle das Torres de Hanói.

Eles dividiram o problema em passos menores para modelos como o Gemini 2.5 Pro, pra ver se eles conseguiam seguir um plano. Pra até 7 discos, funcionou razoavelmente. Mas com 8 ou mais, a performance despencou – exatamente como a Apple observou. A queda é real.

Mas a grande sacada do pessoal da Espanha é a interpretação. Pra eles, não é só falta de "pensamento". Eles apontam que as falhas vêm de como as tarefas são montadas, da estrutura dos prompts (aquilo que você digita pra IA) e dos métodos de otimização estocástica que os modelos usam pra buscar respostas.

Towers of Hanoi: Token na Veia?

Na análise deles sobre as Torres de Hanói, notaram algo interessante: o número de tokens que o modelo usa pra tentar resolver o problema parece estar ligado à "crença" interna dele sobre a possibilidade de solução. Se o modelo acha que dá pra resolver, ele gasta mais recurso (tokens). Se ele "decide" que não dá, ele corta rápido. Pra mim, isso soa como uma forma de gerenciamento interno de incerteza, não necessariamente um planejamento profundo.

Multi-Agentes: Muito Barulho Por Nada?

Tentaram também uma abordagem com múltiplos agentes, onde dois modelos trocavam ideias pra resolver um problema em conjunto. Deu em quê? Muita conversa (altíssimo consumo de token), trocas válidas de movimentos, mas raramente uma solução real. Eles ficavam presos em ciclos. A conclusão: os modelos seguem regras, mas falta a capacidade de reconhecer e executar uma estratégia de alto nível. De novo, a interpretação deles não é só "falta de capacidade", mas também problema na estrutura do prompt e na falta de mecanismos de busca global pela melhor solução.

Esse tipo de nuance é algo que sempre discutimos na nossa comunidade do IA Overflow. Entender *porquê* a IA falha em certas tarefas é crucial pra saber onde e como usar ela de verdade. Se você quer entender melhor como isso afeta o uso prático e trocar ideia sobre esses dilemas da IA, clica no link pra entrar em contato e venha participar!

Travessia do Rio: O Teste da Apple Era (Parte) Inválido?

E a crítica mais direta foi no benchmark de Travessia do Rio, que era um dos pilares do artigo da Apple. Sabe o que o estudo espanhol descobriu? Que *muitos* dos casos de teste usados pela Apple eram matematicamente *insolúveis*. Isso não foi mencionado no artigo original. Tipo, a Apple testou os modelos pra resolver algo impossível e concluiu que eles não conseguiam! Ah, vá!

Os pesquisadores espanhóis só testaram configurações *válidas* do puzzle. E adivinha? Os modelos conseguiram resolver até instâncias bem grandes, com mais de 100 pares de "agentes" pra atravessar.

Interessante notar que os problemas mais difíceis pra eles não eram os maiores, mas os de dificuldade intermediária. Aqueles que têm pouquíssimas soluções válidas e exigem um planejamento super preciso. Isso, sim, sobrecarrega os modelos.

Modelos como Buscadores Estocásticos em Território Desconhecido

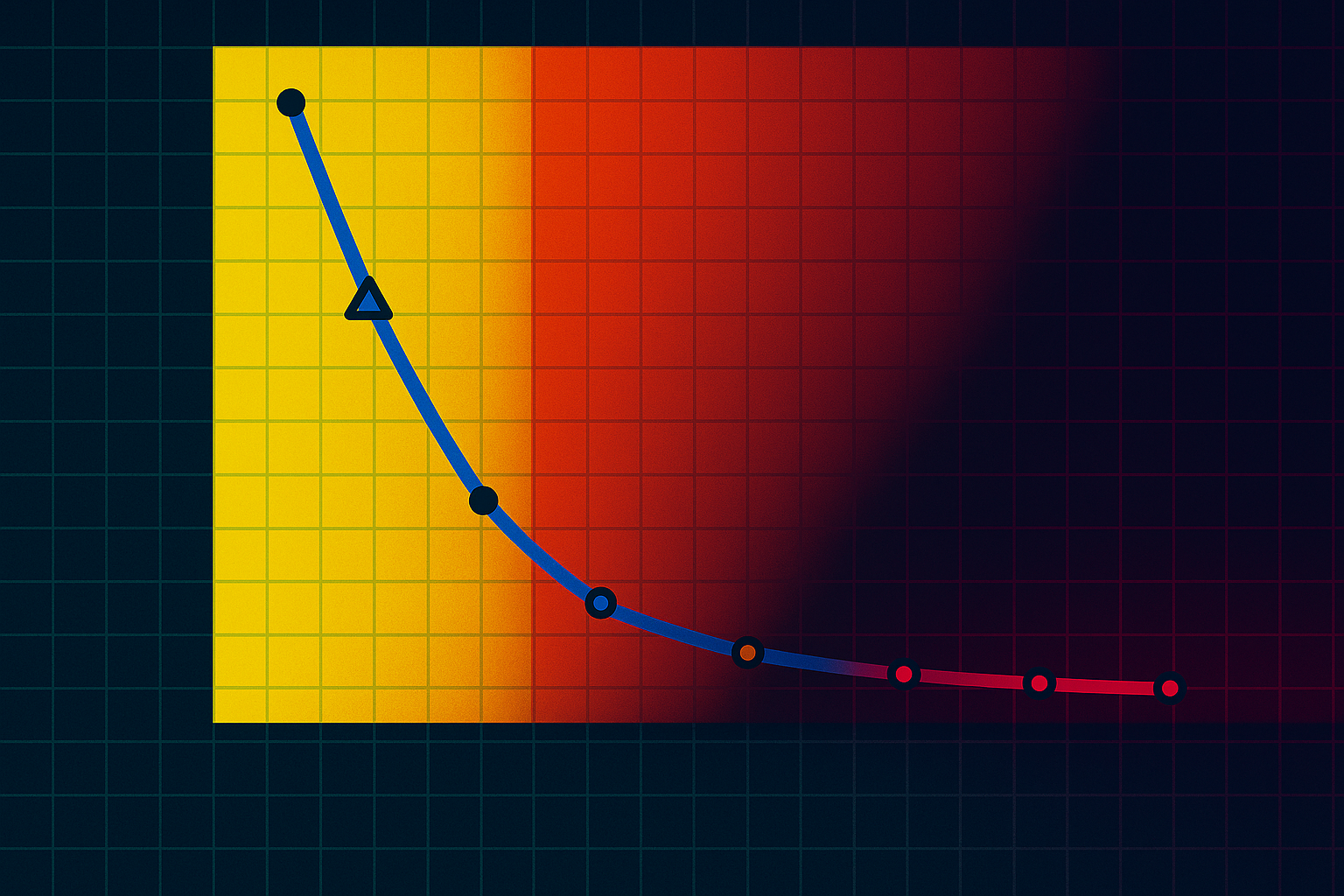

A conclusão final do estudo espanhol é bem diferente da Apple. Eles rejeitam a ideia de que LRMs são incapazes de raciocínio generalizável. Pra eles, os modelos são mais como "buscadores estocásticos (aleatórios) e otimizados por Reforço (RL) em um espaço de estados discreto que mal entendemos".

Nessa visão, a IA não é um "planejador racional", mas um sistema que explora caminhos de solução locais baseados em padrões que aprendeu, com uma capacidade limitada de planejar a longo prazo. E o uso de tokens pode ser um indicador interno da "sensação" de que o modelo tem de que o problema é solúvel.

Pra Fechar

Essa discussão é super importante. Não é sobre a IA "pensar" como nós, mas sobre entender *como* ela tenta resolver problemas complexos. O estudo da Apple levantou um ponto válido: modelos tropeçam. Mas o estudo espanhol adiciona camadas essenciais: talvez o problema esteja mais no *como* testamos e formulamos as tarefas pra eles, e menos numa incapacidade intrínseca de "raciocínio" no sentido que a Apple sugeriu.

Na real, pra mim, isso reforça a ideia de que precisamos ser realistas. Esses modelos são ferramentas poderosas, mas com limitações muito específicas. Entender essas limitações – sejam elas de "raciocínio", de prompt, ou de método de busca – é o que nos permite aplicá-las de forma eficaz no mundo real, em coisas práticas como automação e Vertical AI, onde o contexto é bem definido. O debate continua, e é fascinante!