Google Coloca IA Pesada no Bolso? A Gemma 3n Chega para Celulares

Fala meu povo! Notícia quente chegando aqui na IA Overflow, e essa veio direto do Google: eles acabaram de lançar a Gemma 3n. A grande sacada? Essa IA multimodal foi feita pensando no seu celular, rodando em tempo real. Estava lendo num artigo bem legal no site the-decoder.com sobre isso e achei que valia a pena a gente trocar uma ideia.

O Que Exatamente é Essa Gemma 3n?

Pensa numa inteligência artificial que não entende só texto. A Gemma 3n foi projetada pra ouvir, ver e ler. Ou seja, ela pega input de imagem, áudio, vídeo e texto. Ela fala pra caramba também, gerando texto em mais de 140 idiomas e lidando com as tarefas multimodais em 35 línguas.

Mas o ponto *chave* aqui é que ela foi otimizada pra rodar em dispositivos móveis. Isso é um desafio ENORME. Modelos de IA robustos geralmente precisam de servidores potentes na nuvem. Colocar algo parrudo dentro de um celular, com memória e processamento limitados, exige umas mágicas de engenharia.

As Sacadas de Arquitetura e Otimização

O Google mandou bem em algumas frentes pra fazer isso funcionar. Eles usaram dois tamanhos: um modelo menor, E2B, com 5 bilhões de parâmetros (requerendo só 2 GB de RAM) e um maior, E4B, com 8 bilhões (pedindo 3 GB de RAM). Pra quem mexe com modelos grandes, sabe que 2 ou 3 GB de RAM *é* pouco pra esse tanto de parâmetro rodando localmente.

A arquitetura se chama MatFormer, inspirada naquelas bonecas russas (Matryoshka). A ideia é que o modelo maior (E4B) contém, de certa forma, o modelo menor (E2B) dentro dele. Isso dá uma flexibilidade danada. Dá pra usar as variantes prontas ou até criar tamanhos customizados. No futuro, prometem até alternar entre os tamanhos dinamicamente conforme o uso do celular, pra equilibrar performance e bateria.

Outro truque legal é o Per-Layer Embeddings (PLE). Imagina que a parte mais pesada do 'cérebro' da IA (os pesos principais) fica na memória rápida (GPU/TPU), mas as informações mais detalhadas de cada "camada" do modelo ficam na memória mais lenta (CPU). Isso libera espaço na memória mais cara e limitada do celular, diminuindo o requisito de memória do acelerador.

Áudio e Vídeo em Tempo Real no Celular

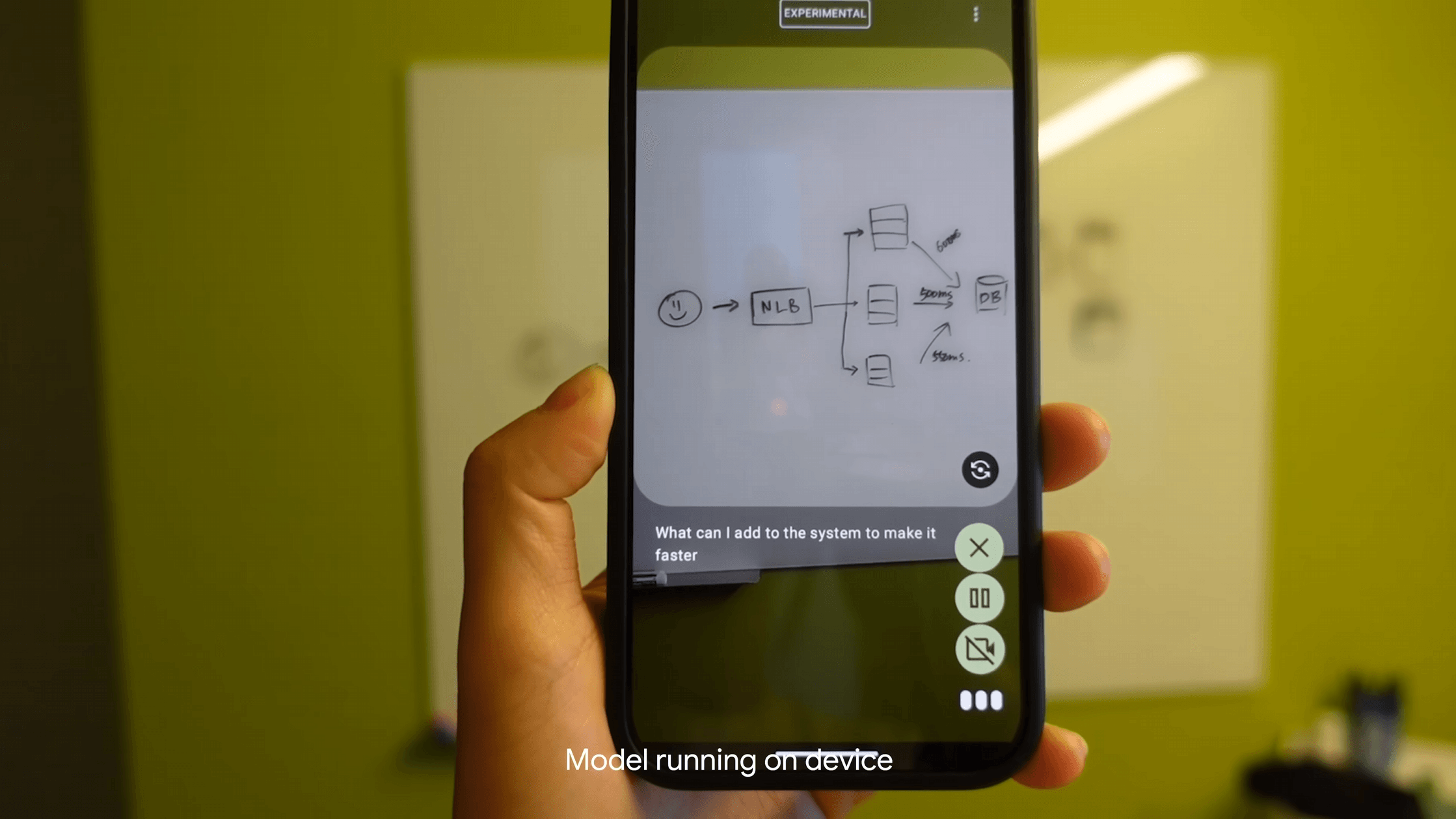

É aqui que a coisa fica interessante na prática. A Gemma 3n processa áudio quase instantaneamente. A cada 160 milissegundos, um pedaço do áudio vira um 'token'. Isso permite coisas como reconhecimento de voz e tradução automática *direto no celular*, sem precisar de internet ou mandar seus dados pra lugar nenhum. Pra vídeo e imagem, usaram um encoder novo (MobileNet-V5) que consegue analisar imagens grandes (768x768) e até 60 imagens por segundo em um Pixel. O Google diz que essa versão otimizada é absurdamente mais rápida e eficiente que as anteriores.

Imagina as possibilidades: seu celular descrevendo em voz alta o que aparece na tela em tempo real, traduzindo uma conversa enquanto ela acontece, ou analisando um objeto que você aponta a câmera sem atraso. É um passo grande pra tornar a IA mais onipresente e útil no dia a dia.

Benchmarks, Testes e Onde Achar

O Google divulgou benchmarks que colocam o modelo E4B no topo da categoria dele (<10B parâmetros). Isso é ótimo no papel. No entanto, lendo o artigo, vi que o desenvolvedor Simon Willison foi testar as versões 'quantizadas' (que são as mais otimizadas pra rodar em hardware limitado) e encontrou diferenças significativas entre elas. É aquela história: o diabo mora nos detalhes e a performance no mundo real pode variar. Isso é algo que rola muito na nossa comunidade IA Overflow, discutir a diferença entre os benchmarks e a performance prática das IAs.

Pra estimular o uso prático, o Google lançou um desafio (Impact Challenge) com $150.000 em prêmios pra quem criar aplicações que usem as capacidades multimodais e offline da Gemma 3n pra resolver problemas reais. Faz todo o sentido focar em casos de uso concreto.

Se você é dev e quer testar, a Gemma 3n já tá disponível em plataformas como Hugging Face e Kaggle, e funciona com várias ferramentas conhecidas (llama.cpp, Docker, etc.). Dá pra colocar pra rodar no Google AI Studio, Cloud Run ou Vertex AI também.

Casos como esse sempre rendem conversas interessantes sobre como adaptar essas novas IAs para diferentes contextos e ver a performance real. Aliás, se você quiser trocar ideia sobre estratégias assim, clica no link pra entrar em contato e entre na comunidade IA Overflow.

No Fim das Contas...

Ter uma IA multimodal robusta capaz de rodar *no seu celular*, em tempo real, sem depender 100% da nuvem, é um avanço importante. Não é o fim de tudo, mas abre um leque de possibilidades pra aplicações que precisam de baixa latência e privacidade (já que os dados ficam no dispositivo). É mais um tijolo nessa construção do futuro da IA, trazendo ela cada vez mais pra perto da gente, no nosso bolso.

Agora é esperar pra ver quais aplicações matadoras a comunidade vai criar com essa ferramenta na mão!